Apple atrasa polêmico sistema de escaneamento de segurança infantil

A Apple está atrasando o lançamento de seus polêmicos recursos de segurança infantil, adiando o sistema que escaneia os uploads de fotos do iCloud e os bate-papos do iMessage em busca de sinais de conteúdo sexual ilegal ou de aliciamento. Anunciado no mês passado , o sistema usaria um banco de dados de terceiros de Material de Abuso Sexual Infantil (CSAM) para procurar sinais de fotos ilegais enviadas para a nuvem, mas foi imediatamente contestado por defensores da privacidade.

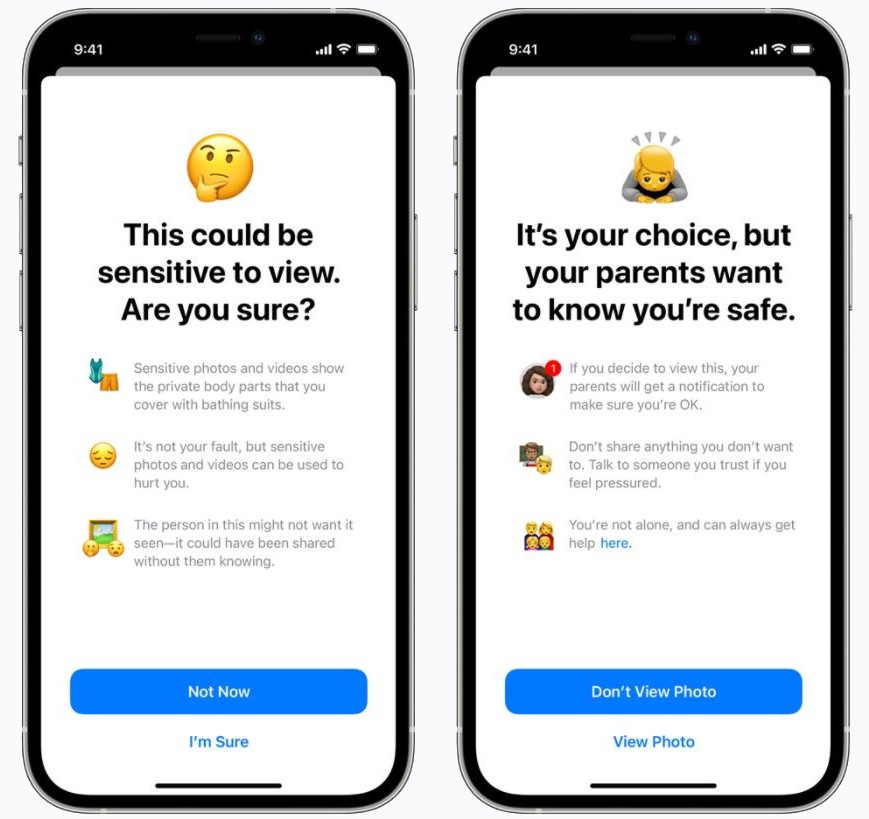

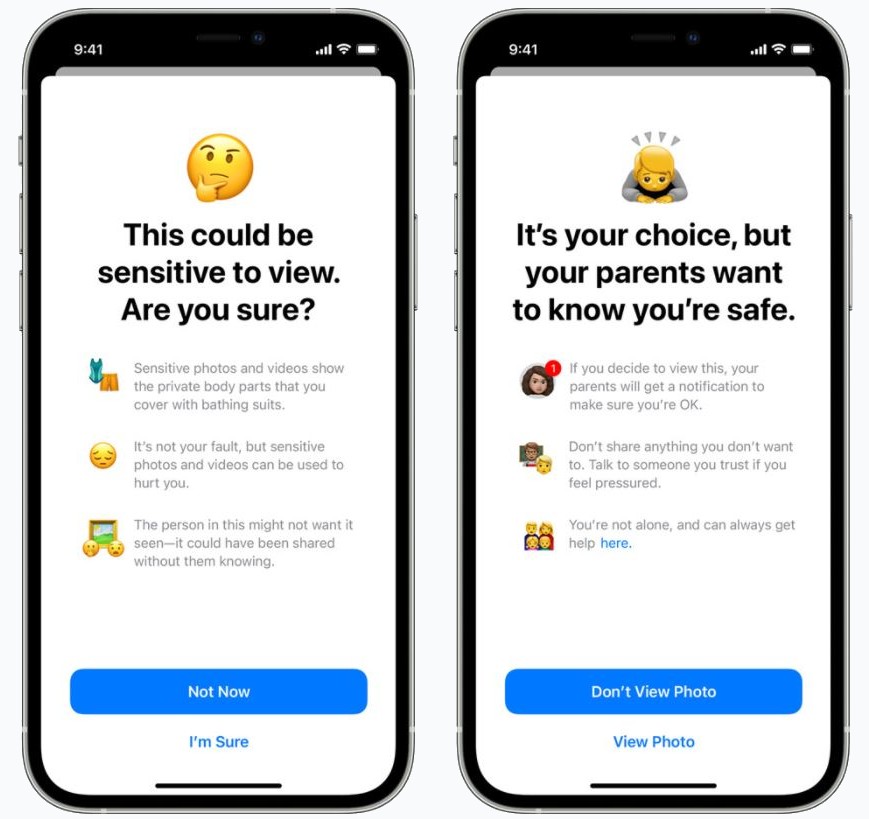

Para aumentar a confusão, a Apple realmente anunciou dois sistemas ao mesmo tempo, embora a funcionalidade estivesse em muitos lugares confundida. Por um lado, o iMessage usaria o reconhecimento de imagem para sinalizar imagens potencialmente explícitas sendo compartilhadas em conversas com usuários jovens. Caso tal foto seja compartilhada, ela será automaticamente censurada e, opcionalmente para usuários mais jovens, os pais notificados sobre o conteúdo.

Ao mesmo tempo, o segundo sistema estaria procurando por CSAM. Apenas as imagens enviadas para o serviço iCloud Photos da Apple seriam monitoradas, usando impressões digitais de imagens geradas por um banco de dados de tal conteúdo ilegal por agências especializadas. Se várias dessas imagens fossem detectadas, a Apple denunciaria o usuário às autoridades.

Visando questões de privacidade e segurança, a Apple incluiu uma série de ressalvas. A digitalização ocorreria no dispositivo, em vez de remotamente, apontou a empresa, e as impressões digitais pelas quais as imagens seriam comparadas não conteriam nenhum conteúdo ilegal real. Mesmo se os uploads fossem sinalizados, haveria uma revisão humana antes de qualquer relatório ser feito.

No entanto, os oponentes do plano foram vocais. O sistema da Apple era uma ladeira escorregadia, eles avisaram, e a empresa de Cupertino – apesar de seus protestos em contrário – sem dúvida enfrentaria pressões da polícia e dos governos para adicionar conteúdo à lista de contas de usuários de mídia que seriam monitoradas. Os jovens também podem ser colocados em risco, foi apontado, e seu próprio direito à privacidade comprometido, se a Apple inadvertidamente os revelar como LGBTQ aos pais por meio de seu sistema de digitalização iMessage.

Até mesmo os executivos da Apple admitiram que o anúncio não foi tratado com o toque hábil que provavelmente exigia. Notícias não oficiais de dentro da empresa sugeriram que as equipes ficaram surpresas com a extensão da reação negativa e por quanto tempo ela persistiu. Agora, a Apple confirmou que não lançará mais os novos sistemas junto com iOS 15, iPadOS 15, watchOS 8 e macOS Monterey ainda este ano.

“No mês passado, anunciamos planos para recursos destinados a ajudar a proteger as crianças de predadores que usam ferramentas de comunicação para recrutá-los e explorá-los, e limitar a disseminação de material de abuso sexual infantil”, disse a Apple em um comunicado hoje. “Com base no feedback de clientes, grupos de defesa, pesquisadores e outros, decidimos reservar um tempo adicional nos próximos meses para coletar informações e fazer melhorias antes de lançar esses recursos de segurança infantil extremamente importantes.”

Para ficar claro, isso não é um cancelamento dos novos sistemas CSAM, apenas um atraso. Ao mesmo tempo, é provável que seja visto como uma vitória para os defensores da privacidade, que embora reconheçam a necessidade de proteger as crianças de comportamentos predatórios, questionam se a varredura generalizada é a melhor maneira de fazer isso.